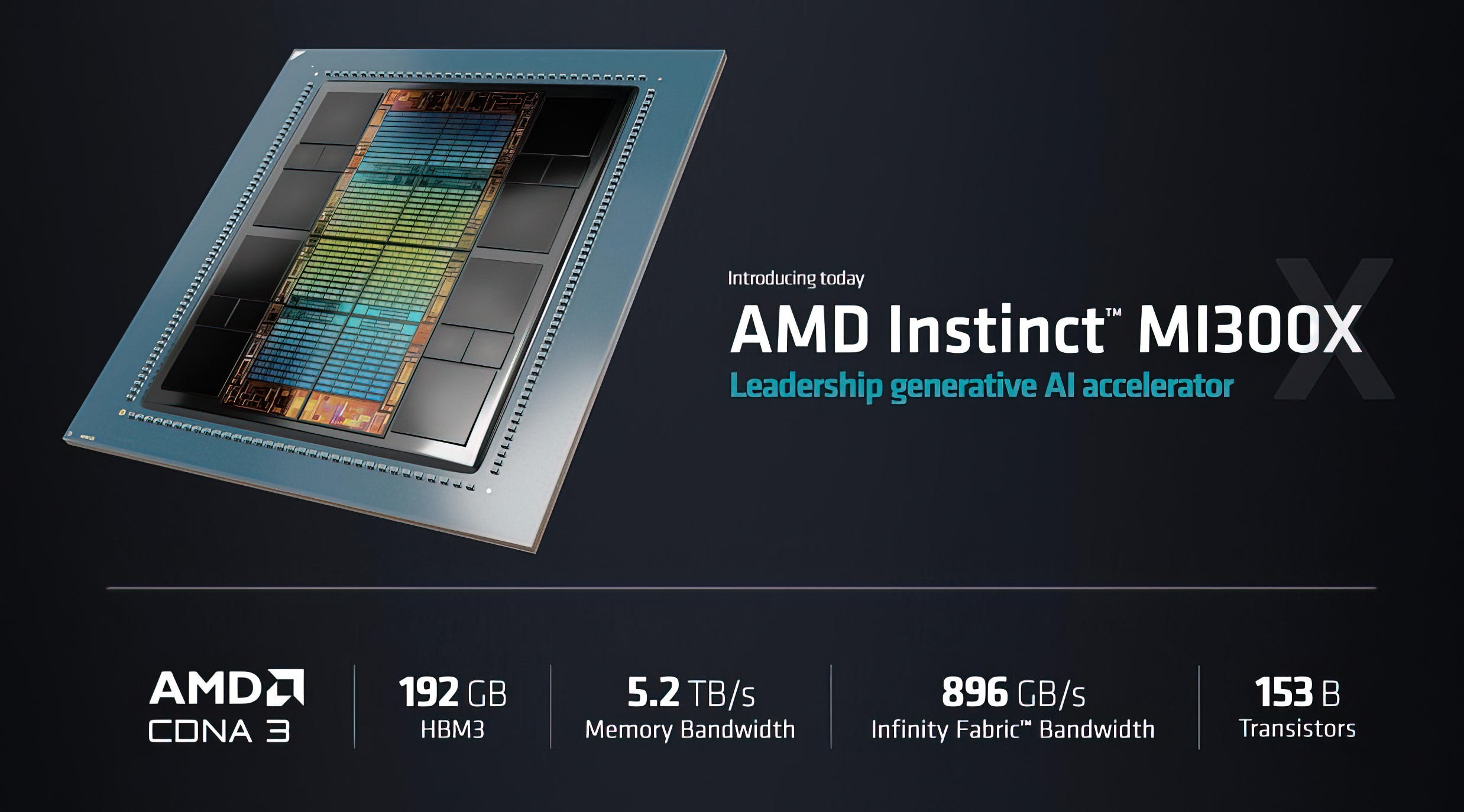

Weder AMD noch Nvidia haben die Absicht, den Leistungsunterschied zwischen dem Instinct MI300X und den H100 (Hopper) GPUs zu bestreiten. Aber AMD hat einige starke Argumente, wenn es FP16 mit vLLM vergleicht, was eine populärere Wahl ist als FP8, das nur mit TensorRT-LLM funktioniert.

Das rote Team kündigte Anfang Dezember den MI300X-Grafikbeschleuniger an und behauptete einen bis zu 1,6-fachen Vorsprung gegenüber Nvidias H100. Vor zwei Tagen hat Nvidia zurückgeschossen und behauptet, AMD habe beim Vergleich des H100 mit TensorRT-LLM seine Optimierungen nicht verwendet. Die Antwort erreichte einen einzelnen H100 gegen achtfache H100-GPUs, während das Llama 2 70B-Chatmodell lief.

Der fortgesetzte Krieg der Benchmark-Ergebnisse und Testszenarien

In dieser jüngsten Antwort erklärte AMD, dass Nvidia eine selektive Auswahl an Inferencing-Workloads verwendet. Es stellte außerdem fest, dass Nvidia diese mit dem hauseigenen TensorRT-LLM auf H100 und nicht mit vLLM, einer weit verbreiteten Open-Source-Methode, bewertet hat. Darüber hinaus verwendete Nvidia den vLLM FP16 Leistungsdatentyp auf AMD, während es seine Ergebnisse mit DGX-H100 verglich, das den TensorRT-LLM mit FP8 Datentyp verwendete, um diese angeblich falsch interpretierten Ergebnisse anzuzeigen.

AMD betonte, dass es in seinem Test vLLM mit dem FP16-Datensatz verwendet hat, da dieser weit verbreitet ist, und vLLM FP8 nicht unterstützt. Es gibt auch den Punkt, dass Server eine Latenz haben, aber anstatt dies zu berücksichtigen, hat Nvidia seine Durchsatzleistung gezeigt und nicht die reale Situation emuliert, so AMD.

AMD führte drei Leistungstests mit Nvidias TensorRT-LLM durch, wobei der letzte bemerkenswerte Test die Latenzergebnisse zwischen MI300X und vLLM mit dem FP16-Datensatz gegen H100 mit TensorRT-LLM gemessen hat. Aber der erste Test beinhaltete einen Vergleich zwischen den beiden mit vLLM auf beiden, also FP16, und für den zweiten Test wurde die Leistung des MI300X mit vLLM verglichen, während TensorRT-LLM verglichen wurde.

AMD verwendete also dasselbe ausgewählte Testszenario, das Nvidia für sein zweites und drittes Testszenario verwendete, und zeigte eine höhere Leistung und geringere Latenz. Das Unternehmen fügte im Vergleich zu H100 weitere Optimierungen hinzu, während vLLM auf beiden Systemen lief, und bot eine 2,1-fache Leistungssteigerung.

Es ist nun an Nvidia, zu entscheiden, wie es darauf reagieren will. Aber Nvidia muss auch anerkennen, dass dies die Industrie dazu zwingen würde, FP16 mit dem geschlossenen System von TensorRT-LLM für die Verwendung von FP8 aufzugeben und damit vLLM für immer aufzugeben. In Bezug auf Nvidias Prämie sagte ein Redditor einmal: „TensorRT-LLM ist kostenlos, genau wie die Dinge, die mit einem Rolls Royce kostenlos sind.“