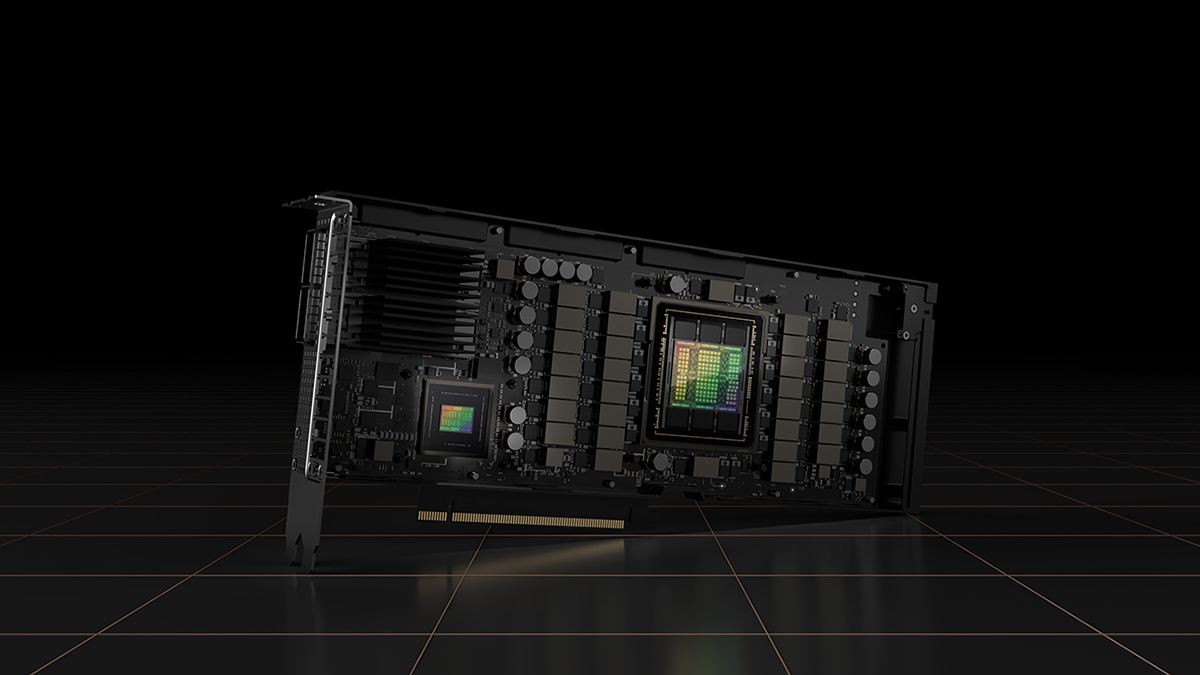

Laut @SawyerMerritt wird Tesla seinen mit Spannung erwarteten Supercomputer im Laufe dieser Woche in Betrieb nehmen. Die Maschine wird für verschiedene Anwendungen im Bereich der künstlichen Intelligenz (KI) eingesetzt werden, aber der Cluster ist so leistungsfähig, dass er auch für anspruchsvolle High-Performance-Computing (HPC)-Workloads verwendet werden könnte. Tatsächlich wird der auf Nvidia H100 basierende Supercomputer einer der leistungsstärksten Rechner der Welt sein.

Der neue Tesla-Cluster wird 10.000 Nvidia H100 Compute GPUs einsetzen, die eine Spitzenleistung von 340 FP64 PFLOPS für technische Berechnungen und 39,58 INT8 ExaFLOPS für KI-Anwendungen bieten werden. Die 340 FP64 PFLOPS von Tesla sind sogar höher als die 304 FP64 PFLOPS von Leonardo, dem weltweit viertstärksten Supercomputer.

Mit seinem neuen Supercomputer steigert Tesla seine Rechenkapazitäten erheblich, um seine FSD-Technologie (Full Self-Driving) schneller als je zuvor zu trainieren. Dies könnte Tesla nicht nur wettbewerbsfähiger machen als andere Autohersteller, sondern das Unternehmen auch zum Besitzer eines der schnellsten Supercomputer der Welt machen.

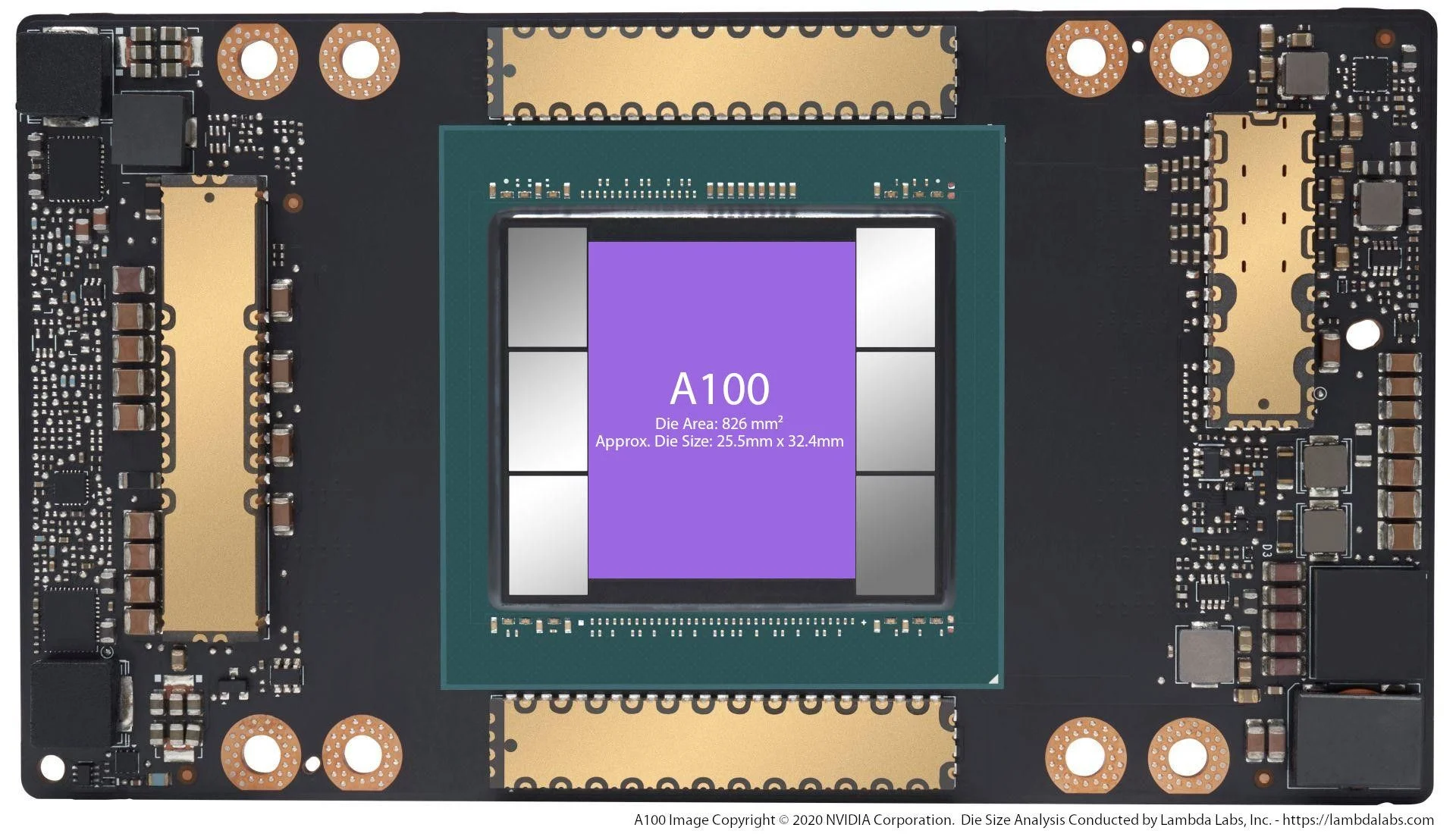

Tomorrow, @Tesla will turn on a massive and very expensive 10,000 unit NVIDIA H100 GPU cluster to help it train FSD. But that got me wondering, what is the difference between these new H100 GPUs and the older A100 graphics processing units (GPUs) Tesla has been using for the last… pic.twitter.com/ZoCjR1SdjI

— Sawyer Merritt (@SawyerMerritt) August 28, 2023

„Dank des Videotrainings in der realen Welt verfügen wir möglicherweise über die größten Trainingsdatensätze der Welt und eine Hot-Tier-Cache-Kapazität von mehr als 200 PB – um Größenordnungen mehr als LLMs“, erklärte Tim Zaman, AI Infra & AI Platform Engineering Manager bei Tesla.

Während der neue H100-basierte Cluster die Trainingsgeschwindigkeit von Tesla drastisch verbessern wird, hat Nvidia Schwierigkeiten, die Nachfrage nach diesen GPUs zu befriedigen. Aus diesem Grund investiert Tesla über 1 Milliarde Dollar in die Entwicklung seines eigenen Supercomputers Dojo, der auf speziell entwickelten, hoch optimierten System-on-Chips basiert.

One final thing in case it wasn’t clear: Next year, Tesla’s own Dojo supercomputer is projected to rank among the most powerful supercomputers globally. This is insane, and something that not many people are talking about. It’s a massive competitive advantage for Tesla.

— Sawyer Merritt (@SawyerMerritt) August 28, 2023

Dojo wird nicht nur das FSD-Training beschleunigen, sondern auch die Datenverarbeitung für die gesamte Fahrzeugflotte von Tesla übernehmen. Gleichzeitig mit Dojo bringt Tesla seinen Nvidia H100-GPU-Cluster online, wodurch das Unternehmen über eine in der Automobilbranche einzigartige Rechenleistung verfügt.

Elon Musk verriet kürzlich, dass Tesla plant, im Jahr 2023 über 2 Milliarden Dollar für KI-Training und weitere 2 Milliarden Dollar im Jahr 2024 speziell für das Computing für FSD-Training auszugeben. Dies unterstreicht das Engagement von Tesla bei der Überwindung von Rechenengpässen und dürfte dem Unternehmen erhebliche Vorteile gegenüber seinen Konkurrenten verschaffen.