Neue Forschungen an den Grenzen der Werkstofftechnik versprechen eine wirklich erstaunliche Leistungssteigerung für Computergeräte. Ein Forscherteam unter der Leitung von Markus Hellbrand et al., das mit der Universität Cambridge verbunden ist, glaubt, dass das neue Material, das auf Hafniumoxidschichten basiert, die durch spannungsändernde Bariumspitzen getunnelt werden, die Eigenschaften von Speicher- und verarbeitungsgebundenen Materialien vereint.

Das bedeutet, dass die Geräte zur Datenspeicherung eingesetzt werden könnten, wobei sie die 10- bis 100-fache Dichte bestehender Speichermedien bieten, oder sie könnten als Verarbeitungseinheit verwendet werden.

Die in der Fachzeitschrift Science Advances veröffentlichten Forschungsergebnisse zeigen uns einen Weg auf, der zu einer weitaus höheren Dichte, Leistung und Energieeffizienz unserer Computergeräte führen könnte. Und zwar so sehr, dass ein typischer USB-Stick, der auf dieser Technologie basiert (die als „Continuous Range“ bezeichnet wird), zwischen 10 und 100 Mal mehr Informationen speichern könnte als die von uns derzeit verwendeten.

Da sich die Dichte des Arbeitsspeichers laut JEDEC alle vier Jahre verdoppelt, würden die Hersteller von Arbeitsspeichern Jahrzehnte brauchen, um die gleiche Dichte zu erreichen, wie sie diese Technologie heute aufweist.

Wir tauchen in Neuronen-Gebiet ein

Das Gerät ist auch ein Licht am Ende des Tunnels der neuromorphen Datenverarbeitung. Wie die Neuronen in unserem Gehirn verspricht das Material (ein sogenannter resistiver Schaltspeicher), sowohl als Speicher- als auch als Verarbeitungsmedium zu funktionieren. Das ist etwas, was bei unserer derzeitigen Halbleitertechnologie einfach nicht möglich ist: Die Transistor- und Materialdesigns unterscheiden sich so sehr zwischen dem, was man für eine Speicherzelle braucht, und dem, was man für eine Verarbeitungszelle braucht (vor allem in Bezug auf die Ausdauer, d. h. die Fähigkeit, keine Leistungseinbußen zu erleiden), dass es derzeit keine Möglichkeit gibt, sie miteinander zu verbinden.

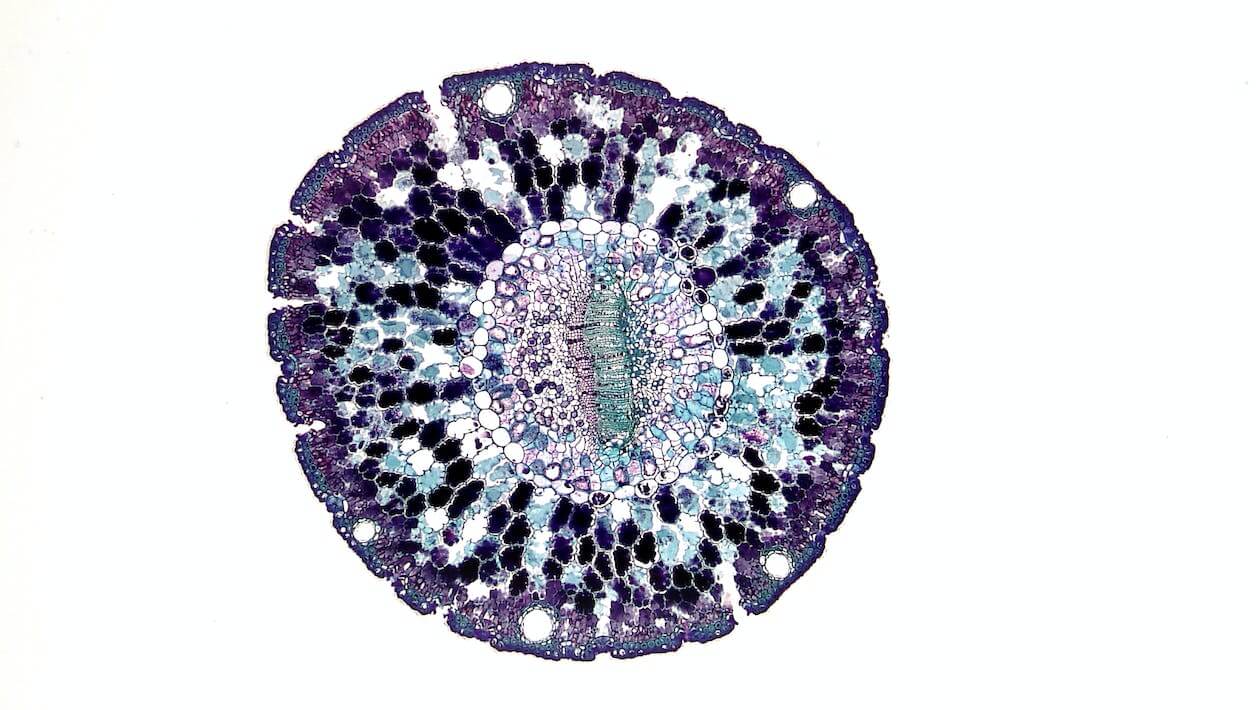

Abb.: eine Zelle credit: Fayette Reynolds

Diese Unfähigkeit, sie zusammenzuführen, bedeutet, dass Informationen kontinuierlich zwischen dem Verarbeitungssystem und seinen verschiedenen Caches (wenn man an eine moderne CPU denkt) sowie seinem externen Speicherpool (ich schaue dich an, die besten DDR5-Kits auf dem Markt) fließen müssen. In der Informatik ist dies als von Neumanns Flaschenhals bekannt, was bedeutet, dass ein System mit getrennten Speicher- und Verarbeitungsfähigkeiten grundsätzlich durch die Bandbreite zwischen beiden begrenzt ist (was normalerweise als Bus bekannt ist). Aus diesem Grund entwickeln alle Halbleiterhersteller (von Intel über AMD und Nvidia bis hin zu vielen anderen) spezielle Hardware, die diesen Informationsaustausch beschleunigt, wie z. B. Infinity Fabric und NVLink.

Energieverbrauch = Wärme

Das Problem ist, dass dieser Informationsaustausch mit Energiekosten verbunden ist, und diese Energiekosten begrenzen derzeit die Obergrenzen der erreichbaren Leistung. Denken Sie daran, dass bei der Zirkulation von Energie auch Verluste auftreten, die zu einem erhöhten Stromverbrauch (eine derzeitige harte Grenze für unsere Hardware-Designs und eine wachsende Priorität bei der Halbleiterentwicklung) sowie zu Wärme führen – eine weitere harte Grenze, die zur Entwicklung von immer exotischeren Kühllösungen geführt hat, um zu versuchen, das Mooresche Gesetz noch eine Weile durchzuhalten. Natürlich gibt es auch den Faktor der Nachhaltigkeit: Es wird erwartet, dass die Computertechnik in nicht allzu ferner Zukunft bis zu 30 % des weltweiten Energiebedarfs verbrauchen wird.

„Dieser explosionsartige Anstieg des Energiebedarfs ist zu einem großen Teil auf die Unzulänglichkeiten der derzeitigen Computer-Speichertechnologien zurückzuführen“, erklärt der Erstautor Dr. Markus Hellenbrand vom Cambridge Department of Materials Science and Metallurgy. „Bei herkömmlichen Computern gibt es auf der einen Seite den Speicher und auf der anderen Seite die Verarbeitung, und die Daten werden zwischen beiden hin- und hergeschoben, was sowohl Energie als auch Zeit kostet.

Die Vorteile der Verschmelzung von Speicher und Verarbeitung sind, wie Sie sich vorstellen können, ziemlich spektakulär. Während herkömmliche Speicher nur zwei Zustände annehmen können (eins oder null, daher die „binäre“ Bezeichnung), kann ein resistiv schaltender Speicher seinen Widerstand durch eine Reihe von Zuständen ändern. Dadurch kann er mit einer größeren Vielfalt an Spannungen arbeiten, was wiederum die Speicherung von mehr Informationen ermöglicht.

Zwei Funktionen in einem

Eine Möglichkeit, die Verarbeitung von der Speicherung zu unterscheiden, besteht darin, zu sagen, dass die Verarbeitung bedeutet, dass die Informationen so schnell geschrieben und umgeschrieben werden (Hinzufügungen oder Subtraktionen, Umwandlungen oder Umstrukturierungen), wie es ihr Schaltzyklus erfordert. Speichern bedeutet, dass die Informationen für einen längeren Zeitraum statisch sein müssen – vielleicht, weil sie z. B. Teil des Windows- oder Linux-Kernels sind.

Um diese Synapsen, wie sie in dem Papier genannt werden, zu bauen, musste das Forscherteam einen Weg finden, um einen Engpass in der Werkstofftechnik zu überwinden, der als Gleichmäßigkeitsproblem bekannt ist. Da Hafniumoxid (HfO2) keine Struktur auf atomarer Ebene besitzt, werden die Hafnium- und Sauerstoffatome, die für die Isolationseigenschaften verantwortlich sind, unregelmäßig abgelagert. Je geordneter die atomare Struktur ist, desto geringer ist der Widerstand und desto höher sind Geschwindigkeit und Effizienz. Das Team fand jedoch heraus, dass die Ablagerung von Barium (Ba) in den dünnen Schichten aus unstrukturiertem Hafniumoxid zu hoch geordneten Bariumbrücken (oder Spikes) führte. Und weil ihre Atome besser strukturiert sind, können diese Brücken den Elektronenfluss besser ermöglichen.

Elektronenbildgebung

Die mit der Transmissionselektronenmikroskopie (TEM) aufgenommenen Fotos zeigen die erhöhte Ordnung bei der Ablagerung von Hafniumoxid (ungeordnete und natürliche Ablagerung, wie in Bild A), wenn es durch die dynamisch veränderlichen Bariumspitzen getunnelt wird. (Bildnachweis: Universität Cambridge/Markus Hellbrand et al.)

Doch der Spaß begann, als das Forscherteam herausfand, dass sie die Höhe der Bariumspitzen dynamisch verändern können, was eine feinkörnige Steuerung ihrer elektrischen Leitfähigkeit ermöglicht. Sie fanden heraus, dass die Spikes mit einer Geschwindigkeit von ~20ns schalten konnten, d. h. sie konnten innerhalb dieses Zeitfensters ihren Spannungszustand ändern (und somit verschiedene Informationen speichern). Sie fanden eine Schaltdauer von >10^4 Zyklen, mit einem Speicherfenster von >10. Das bedeutet, dass das Material zwar schnell ist, aber die maximale Anzahl der Spannungszustandsänderungen, die es derzeit aushalten kann, bei etwa 10 000 Zyklen liegt – kein schlechtes Ergebnis, aber auch kein erstaunliches.

Das entspricht der Ausdauer der MLC (Multi-Level Cell)-Technologie, was ihre Anwendung natürlich einschränkt – die Verwendung dieses Materials als Verarbeitungsmedium (wo Spannungszustände schnell geändert werden, um einen Speicher für Berechnungen und deren Zwischenergebnisse zu haben).

100 TeraByte USB-Sticks?

Nach groben Berechnungen ergibt sich aus den ~20 ns Schaltzeit eine Betriebsfrequenz von 50 MHz (umgerechnet in Zyklen pro Nanosekunde). Wenn das System verschiedene Zustände mit voller Geschwindigkeit verarbeitet (z. B. als GPU oder CPU), würde das bedeuten, dass die Barium-Brücken etwa bei der 0,002-Sekunden-Marke aufhören zu funktionieren (und an ihre Belastungsgrenze stoßen) (man bedenke, dass es nur mit 50 MHz arbeitet). Das scheint für eine Verarbeitungseinheit nicht leistungsfähig genug zu sein.

Aber für die Speicherung? Hier kommt der USB-Stick ins Spiel, dessen Speicherkapazität 10- bis 100-mal dichter ist. Diese Synapse-Geräte können auf viel mehr Spannungszwischenzustände zugreifen als selbst die dichteste NAND-Technologie in den geräumigsten USB-Sticks von heute – um den Faktor 10 oder 100.

Wer würde nicht gerne einen 10 TeraByte oder sogar 100 TeraByte großen „USB 7“-Stick in den Händen halten?

An der Ausdauer und der Schaltgeschwindigkeit der Barium-Brücken muss noch gearbeitet werden, aber es sieht so aus, als sei das Design bereits ein verlockender Proof of Concept. Noch besser ist, dass die Halbleiterindustrie bereits mit Hafniumoxid arbeitet, so dass es weniger Alpträume in Bezug auf Werkzeuge und Logistik gibt.

Unvorstellbare Möglichkeiten!

Aber hier ist eine besonders geniale Produktmöglichkeit: Stellen Sie sich vor, die Technologie wird so weit verbessert, dass sie für die Entwicklung eines AMD- oder Nvidia-Grafikprozessors (der heutzutage mit etwa 2 GHz arbeitet) hergestellt und verwendet werden kann. Es gibt eine Welt, in der diese Grafikkarte mit einem zurückgesetzten Werkszustand geliefert wird, in dem sie vollständig als Speicher arbeitet (stellen Sie sich nun eine Grafikkarte mit 10 TB Speicher vor, was unserem hypothetischen USB-Stick entspricht).

Stellen Sie sich eine Welt vor, in der das, was AMD und Nvidia anbieten, im Wesentlichen programmierbare GPUs sind, mit auf kontinuierlicher Reichweite basierenden GPU-Chips, die in Bezug auf die maximale Speicherkapazität aufeinander abgestimmt sind (denken Sie daran, dass die 10 bis 100 dichter sind als der aktuelle USB-Stick). Wenn Sie als KI-Liebhaber versuchen, Ihr eigenes Large Language Model (LLM) zu erstellen, können Sie Ihren Grafikprozessor so programmieren, dass genau die richtige Menge dieser synthetischen Bausteine, dieser neuromorphen Transistoren, die Verarbeitungsfunktionen ausführt – es ist nicht abzusehen, wie viele Billionen Parameter die Modelle mit zunehmender Komplexität am Ende haben werden, so dass der Speicher immer wichtiger wird.

Wenn man in der Lage wäre, zu bestimmen, ob die Transistoren in der Grafikkarte genau als Speicher oder genau als Rechner für die Grafik verwendet werden, um die Grafikeinstellungen auf elf zu stellen, wäre das ganz dem Endbenutzer überlassen, vom Gelegenheitsspieler bis zum High Performance Computing (HPC)-Installateur. Selbst wenn das eine gewisse Verschlechterung der Langlebigkeit von Teilen unseres Chips bedeuten würde.

Wir aktualisieren sie sowieso ständig, nicht wahr?

Aber wir wollen nicht zu weit vorgreifen. Auch wenn dies kein so gefährliches Thema ist wie die Entwicklung der KI und ihre Regulierung, hat es wenig Sinn, so weit voraus zu träumen. Wie jede Technologie wird auch diese kommen – wenn sie bereit ist, falls sie es jemals sein wird.

Header Credit: David Cassolato