Mit Llama 3 stellte Meta ein neues Sprachmodell vor, welches nicht nur die Leistungsfähigkeit anderer Modelle übertrifft. Gleichwohl wurde es auch mit einer Rekordmenge an Daten trainiert. Wie der KI-Forscher Andrej Karpathy jedoch auf Twitter erläuterte, gilt das Modell nach wie vor als untertrainiert. Nur Vermutungen lassen derzeit erahnen, wozu KI-Modelle in ein paar Jahren fähig sein werden.

Der KI-Hype ist ungebrochen

Schon vor ein paar Tagen berichteten wir darüber, dass der KI-Hype und die Entwicklung unterschiedlichster Modelle laut des AI Index Reports der Stanford University auf der ganzen Welt alleine im Jahr 2023 erheblich zugenommen hat.

Gleichwohl fragen sich Experten, wann die KI den Menschen in Bezug auf seine Denkfähigkeit einholt. In diesem Bezug zeigen einige Berichte, dass dies mit hoher Wahrscheinlichkeit noch ein paar Jahre dauern wird. Doch daneben gibt es noch ein weiteres Problem, das derzeit möglicherweise die Entwicklung der KI ausbremst.

Metas Llama 3 gilt laut Experten als untertrainiert

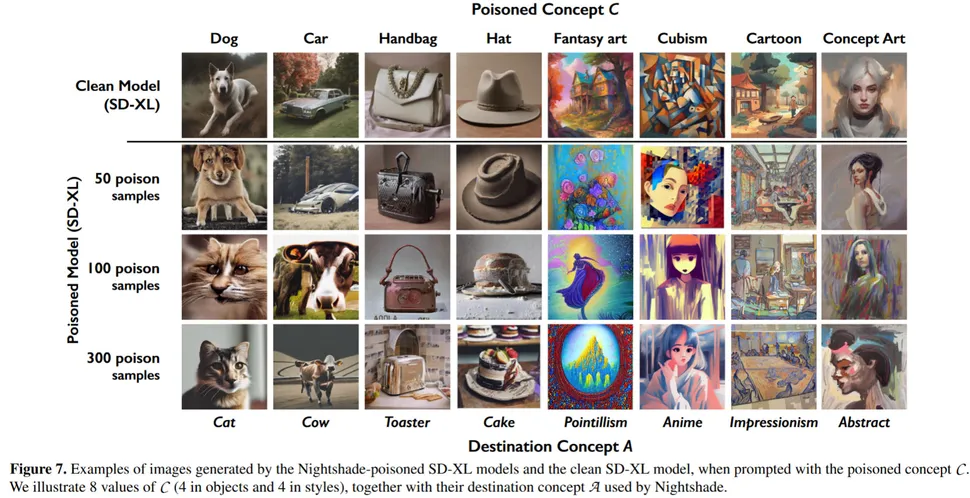

Das erst jüngst vorgestellte Sprachmodell Llama 3 zeigt sehr gut, warum die KI möglicherweise den Menschen noch immer nicht eingeholt hat. Hier zunächst ein paar Fakten:

- Die KI wurde zum Finetuning mit etwa 10 Millionen qualitativ hochwertigen Beispielen gefüttert.

- Das Modell trainierte mit etwa 15 Billionen Token.

- Die Datenmenge überschritt jene, die zum Training von Llama 2 eingesetzt wurde, um Welten.

Bei alldem hielt man sich an die Datenmengen, die laut den Chinchilla-Skalierungsgesetzen als optimal gilt. Zu bedenken gilt außerdem, dass für ein 8-Milliarden Modell etwa 200 Milliarden Trainings-Token ausreichen sollten. Unter diesem Aspekt würde auch die Rechenleistung optimal genutzt, sodass das System effizient arbeiten kann. Fakt ist allerdings, dass Llama 3 alleine auf die 75-fache Datenmenge zurückgriff und somit über dem optimalen Durchschnitt lag.

Seine maximale Recheneffizienz sei trotz der hohen Menge jedoch noch lange nicht erreicht und ausgeschöpft. Laut Andrej Karpathy, einem Gründungsmitglied von OpenAI und ehemaligem KI-Chef von Tesla sei das System eher untertrainiert.

Die Leistung des Modells steigere selbst mit dem Training von 15 Billionen Token noch weiter log-linear an. Sämtliche Erkenntnisse fasste Karpathy in einem eigenen Post auf der Plattform X zusammen.

Congrats to @AIatMeta on Llama 3 release!! 🎉https://t.co/fSw615zE8S

Notes:Releasing 8B and 70B (both base and finetuned) models, strong-performing in their model class (but we'll see when the rankings come in @ @lmsysorg :))

400B is still training, but already encroaching…— Andrej Karpathy (@karpathy) April 18, 2024

Die Grenze des Machbaren ist noch nicht erreicht

Karpathy bezifferte die Defizite des Systems im Blogbeitrag noch weiter. Laut ihm sind die Sprachmodelle derzeit um den Faktor 100 oder 1000 untertrainiert, sodass sie noch lange nicht ihr maximales Potenzial erreicht hätten.

Infolge des aktuellen KI-Hypes sei es jedoch absehbar, dass zukünftig auch noch weiter an dieser Entwicklung gearbeitet wird und weitere Modelle erscheinen, die nicht nur kompakter sind, sondern auch in Langzeit trainieren und so einen noch besseren Schluss über die Leistungsfähigkeit zulassen.

Wann die Grenze erreicht sei, lässt sich derzeit noch nicht abschätzen. Es ist jedoch absehbar, dass es binnen der nächsten Jahre diesbezüglich spannend werden könnte.

Quellen: X/Twitter, Andrej Karpathy