Nvidia hat fleißig an weiteren Verbesserungen seiner Suite von AI/ML (Artificial Intelligence/Machine Learning) und LLM (Large Language Model) Tools gearbeitet. Die neueste Ergänzung sind TensorRT und TensorRT-LLM, die die Leistung von Consumer-GPUs und vielen der besten Grafikkarten für Aufgaben wie Stable Diffusion und Llama 2 Texterzeugung optimieren sollen. Wir haben einige von Nvidias neuesten GPUs mit TensorRT getestet und festgestellt, dass die Leistung in Stable Diffusion um bis zu 70% verbessert wurde. TensorRT sollte jetzt auf Nvidias Github-Seite zum Download verfügbar sein, obwohl wir für diesen ersten Blick einen frühen Zugang hatten.

Wir haben im letzten Jahr viel Bewegung in Stable Diffusion gesehen. Bei unserem ersten Blick haben wir das Webui von Automatic1111 verwendet, das zunächst nur Nvidia-GPUs unter Windows unterstützt hat. Seitdem ist die Zahl der Forks und alternativen Tools zur Erzeugung von Text-zu-Bild-KI explodiert, und sowohl AMD als auch Intel haben feiner abgestimmte Bibliotheken veröffentlicht, die die Lücke zur Leistung von Nvidia etwas geschlossen haben. Unsere neuesten Stable Diffusion-Benchmarks finden Sie in unseren AMD RX 7800 XT- und RX 7700 XT-Tests. Jetzt ist Nvidia bereit, die Lücke mit TensorRT wieder zu vergrößern.

Die Grundidee ähnelt dem, was AMD und Intel bereits getan haben. Durch die Nutzung von ONNX, einem offenen Format für KI- und ML-Modelle und Operatoren, wird das stabile Diffusionsmodell Hugging Face in ein ONNX-Format konvertiert. Von dort aus können Sie die Leistung für die von Ihnen verwendete GPU weiter optimieren. Es dauert ein paar Minuten (oder manchmal mehr), bis TensorRT die Einstellungen vorgenommen hat, aber sobald dies abgeschlossen ist, sollten Sie einen erheblichen Leistungsschub zusammen mit einer besseren Speichernutzung erhalten.

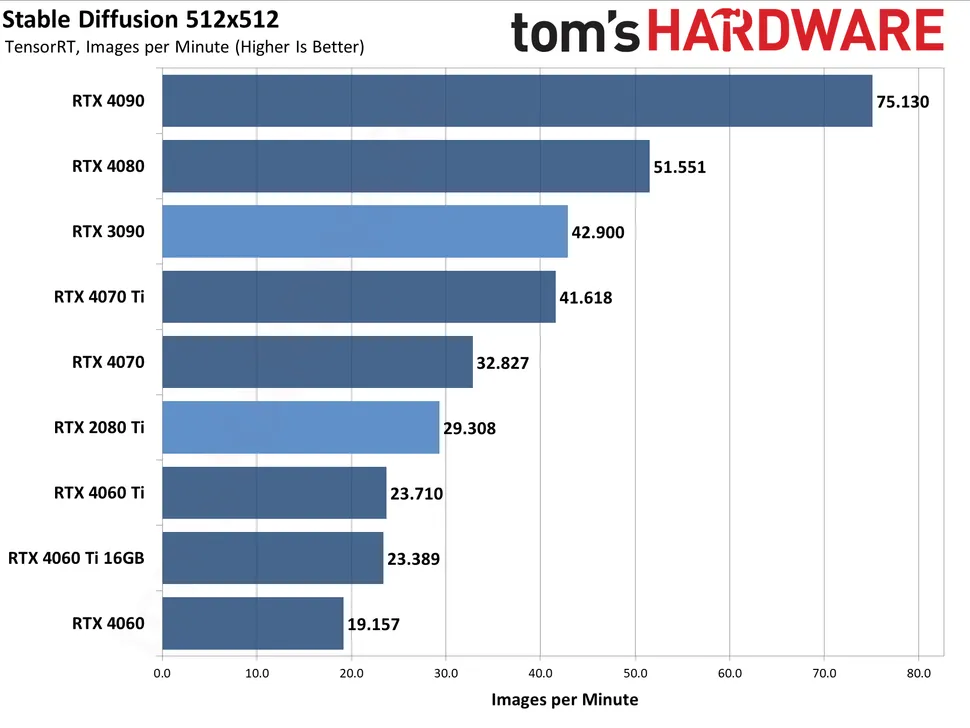

Wir haben alle aktuellen RTX 40-GPUs von Nvidia durch den Tuning-Prozess laufen lassen (jeder muss für eine optimale Leistung separat durchgeführt werden), zusammen mit dem Testen der Basisleistung von Stable Diffusion und der Leistung mit Xformers. Wir sind noch nicht ganz bereit für ein vollständiges Update, das die Leistung von AMD, Intel und Nvidia in Stable Diffusion vergleicht, da wir eine Reihe zusätzlicher GPUs mit den neuesten optimierten Tools erneut testen, daher konzentriert sich dieser erste Blick nur auf Nvidia-GPUs. Wir haben eine RTX 30-Serie (RTX 3090) und eine RTX 20-Serie (RTX 2080 Ti) einbezogen, um zu zeigen, wie sich die TensorRT-Gewinne auf die gesamte RTX-Reihe von Nvidia auswirken.

Jede der obigen Galerien mit 512×512 und 768×768 verwendet die Stable Diffusion 1.5 Modelle. Wir sind von 2.1 auf 1.5 „zurückgegangen“, da die Entwicklergemeinschaft im Allgemeinen die Ergebnisse von 1.5 bevorzugt, obwohl die Ergebnisse mit den neueren Modellen in etwa die gleichen sein sollten. Für jede GPU haben wir verschiedene Stapelgrößen und Stapelanzahlen ausgeführt, um den optimalen Durchsatz zu ermitteln, wobei wir insgesamt 24 Bilder pro Durchlauf erzeugt haben. Dann haben wir den Durchsatz von drei separaten Läufen gemittelt, um die Gesamtrate zu ermitteln – so wurden für jedes Modellformat und jeden Grafikprozessor insgesamt 72 Bilder erzeugt (ohne verworfene Läufe).

Beim Gesamtdurchsatz kommen verschiedene Faktoren ins Spiel. Die GPU-Rechenleistung spielt eine große Rolle, ebenso die Speicherbandbreite. Die VRAM-Kapazität ist eher ein untergeordneter Faktor, abgesehen davon, dass sie möglicherweise größere Bildauflösungen oder Stapelgrößen ermöglicht – es gibt Dinge, die man mit 24 GB VRAM machen kann, die mit 8 GB nicht möglich sind, mit anderen Worten. Auch die Größe des L2-Cache könnte eine Rolle spielen, obwohl wir nicht versucht haben, dies direkt zu modellieren. Was wir sagen können, ist, dass die 4060 Ti 16GB- und 8GB-Karten, die im Grunde die gleichen Spezifikationen haben (leicht unterschiedliche Taktraten aufgrund des Custom-Modells bei der 16GB-Karte), nahezu identische Leistung und optimale Stapelgrößen aufweisen.