Der chinesische GPU-Hersteller Moore Threads hat mit der MTT S4000 seine neueste Grafikkarte für KI- und Data-Center-Compute-Workloads angekündigt. Das brandneue Flaggschiff des Unternehmens wird im KUAE Intelligent Computing Center zum Einsatz kommen, einem Rechenzentrum mit Clustern aus je 1.000 S4000-GPUs. Moore Threads arbeitet auch mit vielen anderen chinesischen Unternehmen, darunter Lenovo, zusammen, um sein KUAE-Hardware- und Software-Ökosystem auf den Weg zu bringen.

Obwohl Moore Threads nicht alles über seinen S4000-Grafikprozessor verraten hat, ist er mit Sicherheit eine große Verbesserung gegenüber dem S2000 und S3000. Im Vergleich zur S2000 hat die S4000 mehr als die doppelte FP32-Leistung, die fünffache INT8-Leistung, 50% mehr VRAM und vermutlich auch viel mehr Speicherbandbreite. Das neue Flaggschiff verwendet außerdem die MUSA-Architektur (Moore Threads Unified System Architecture) der zweiten Generation, während die S2000/S3000 die Architektur der ersten Generation verwendeten.

(Disclaimer: Moore Threads listet sowohl das S2000 als auch das S3000 als „First Generation MUSA“, aber andere haben gesagt, dass das S2000 und das S80 eine „Chunxiao-Architektur der zweiten Generation“ verwendet haben. Es wäre sinnvoller, wenn der S3000 „zweite Generation“ wäre, da Moore Threads den S4000 ausdrücklich als „dritte Generation“ bezeichnet, obwohl wir noch keine Produktseite dafür haben).

Im Vergleich zu Modellen von Nvidia ist die S4000 besser als die Turing-basierten Tesla-Server-GPUs aus dem Jahr 2018, liegt aber immer noch hinter Ampere und Ada Lovelace, die 2020 bzw. 2022 auf den Markt kommen. Dem S4000 fehlt es vor allem an roher Leistung, aber er hat immer noch ziemlich viel Speicherkapazität und Bandbreite, was für die KI- und Large-Language-Model (LLM)-Workloads, für die Moore Threads sein Flaggschiff einsetzen will, nützlich sein könnte.

Die S4000 verfügt auch über kritische GPU-zu-GPU-Datenfähigkeiten, mit einer 240 GB/s-Datenverbindung von einer Karte zur anderen und RDMA-Unterstützung. Das ist weit entfernt von der NVLink-Bandbreite von 900 GB/s auf Hopper, aber die S4000 ist vermutlich eine viel schwächere GPU, so dass eine so hohe Bandbreite Overkill ist.

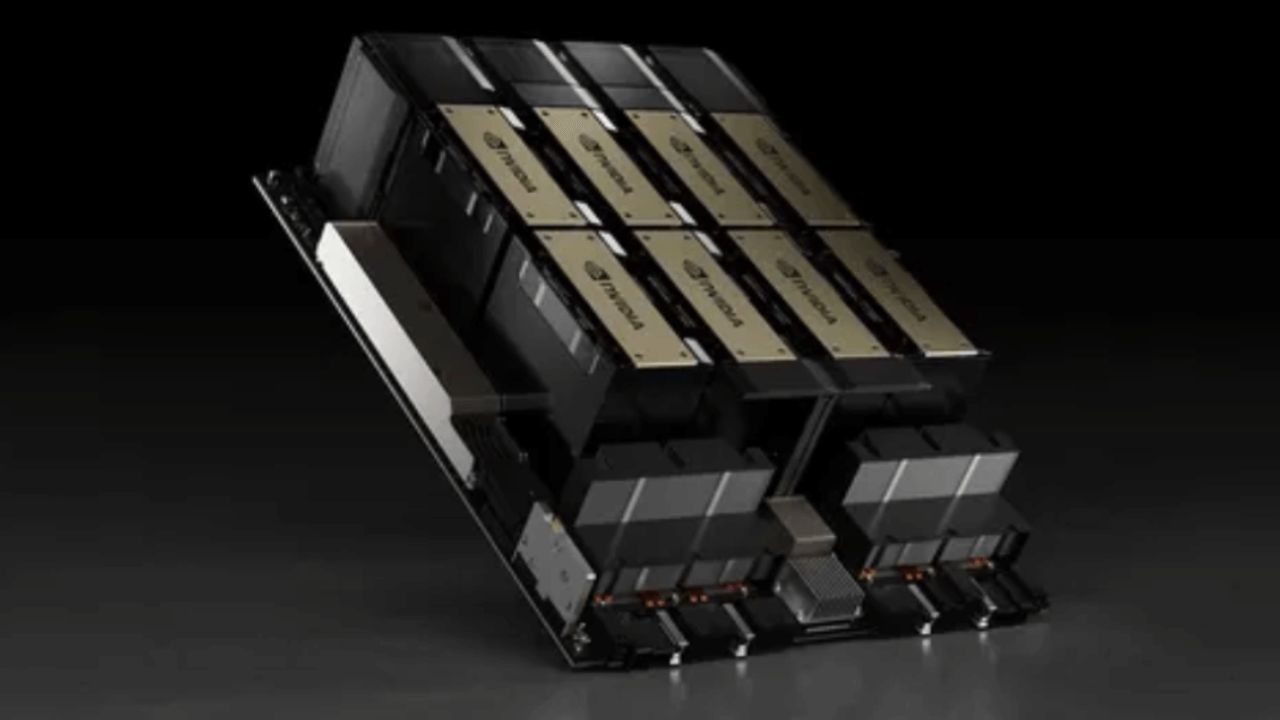

Neben der S4000 hat Moore Threads auch sein KUAE Intelligent Computing Center vorgestellt. Das Unternehmen beschreibt es als eine „Komplettlösung, die Software und Hardware integriert“, mit der voll ausgestatteten S4000 GPU als Herzstück. Die KUAE-Cluster verwenden MCCX D800 GPU-Server, die jeweils mit acht S4000-Karten ausgestattet sind. Moore Threads sagt, dass jeder KUAE Kilocard Cluster 1.000 GPUs hat, was insgesamt 125 MCCX D800 Server pro Cluster bedeutet.

Auf der Softwareseite unterstützt KUAE nach Angaben von Moore Threads Mainstream-Großsprachenmodelle wie GPT und Frameworks wie DeepSpeed. Das MUSIFY-Tool des Unternehmens ermöglicht es dem S4000 offenbar, mit dem auf Nvidia-GPUs basierenden CUDA-Software-Ökosystem zu arbeiten, wodurch Moore Threads und Chinas Softwareindustrie das Rad nicht neu erfinden müssen.

Ein KUAE-Cluster kann offenbar ein KI-Modell in etwa einem Monat trainieren, obwohl dies stark von einigen Besonderheiten abhängt. Laut Moore Threads dauert das Training des Aquila2-Modells mit 70 Milliarden Parametern 33 Tage, aber wenn man die Parameter auf 130 Milliarden erhöht, verlängert sich die Trainingszeit auf 56 Tage.

Diese Art von Hardware- und Software-Ökosystem zu unterstützen, wäre für jedes Unternehmen eine Herausforderung, aber für Moore Threads wäre es nahezu unmöglich, es allein zu schaffen, insbesondere nachdem es viele seiner Mitarbeiter entlassen musste. Vermutlich hat das Unternehmen deshalb die Intelligent Computing and Large Model Ecological Alliance gegründet, eine Partnerschaft zwischen Moore Threads und mehreren anderen chinesischen Unternehmen. Der einheimische chinesische GPU-Hersteller erhielt vor allem Unterstützung von Lenovo, das auch international vertreten ist.