Der Mitbegründer und CEO von Lamini, einem Startup für künstliche Intelligenz (KI) und große Sprachmodelle (LLM), hat ein Video auf Twitter/X gepostet, in dem er sich über die anhaltende GPU-Knappheit von Nvidia lustig macht. Der Lamini-Chef ist im Moment ziemlich selbstgefällig, und das scheint vor allem daran zu liegen, dass das LLM des Unternehmens ausschließlich auf leicht verfügbaren AMD-GPU-Architekturen läuft. Außerdem behauptet das Unternehmen, dass AMD-GPUs, die ROCm verwenden, „Software-Parität“ mit der bisher dominierenden Nvidia-CUDA-Plattform erreicht haben.

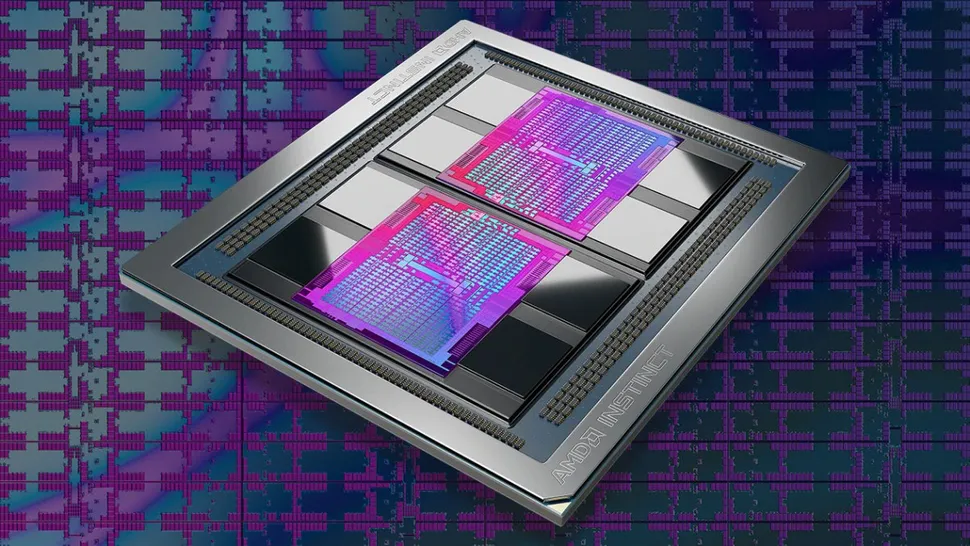

Das Video zeigt Sharon Zhou, CEO von Lamini, bei der Überprüfung eines Ofens auf der Suche nach einigen AI LLM beschleunigenden GPUs. Zunächst begibt sie sich in eine Küche, die oberflächlich betrachtet Jensen Huangs berühmtem kalifornischen Coquina ähnelt, aber bei der Überprüfung des Ofens stellt sie fest, dass dieser „52 Wochen Vorlaufzeit hat – nicht fertig“. Frustriert schaut Zhou auf dem Grill im Hof nach, und dort steht ein frisch gegrillter AMD Instinct GPU zur Mitnahme bereit.

Wir kennen die technischen Gründe nicht, warum Nvidia-GPUs lange im Ofen gegart werden müssen, während AMD-GPUs auf dem Grill zubereitet werden können. Hoffentlich können unsere Leser in den Kommentaren etwas Licht in dieses Halbleiter-Rätsel bringen.

Just grilling up some GPUs 💁🏻♀️

Kudos to Jensen for baking them first https://t.co/4448NNf2JP pic.twitter.com/IV4UqIS7OR

— Sharon Zhou (@realSharonZhou) September 26, 2023

Wenn wir uns Lamini, das führende LLM-Startup, genauer ansehen, sehen wir, dass mit ihnen nicht zu spaßen ist. CRN hat am Dienstag einige Hintergrundinformationen über das in Palo Alto, Kalifornien, ansässige Startup veröffentlicht. Einige der wichtigen Dinge, die in der Berichterstattung erwähnt werden, sind die Tatsache, dass Lamini-CEO Sharon Zhou ein Experte für maschinelles Lernen ist und CTO Greg Diamos ein ehemaliger Nvidia CUDA-Softwarearchitekt ist.

Es hat sich herausgestellt, dass Lamini im vergangenen Jahr „heimlich“ LLMs auf AMD Instinct GPUs ausgeführt hat, wobei eine Reihe von Unternehmen während der Testphase von privaten LLMs profitiert hat. Der bemerkenswerteste Kunde von Lamini ist wahrscheinlich AMD, der „Lamini in unserem internen Kubernetes-Cluster mit AMD Instinct GPUs einsetzt und das Finetuning nutzt, um Modelle zu erstellen, die auf der AMD-Codebasis über mehrere Komponenten für spezifische Entwickleraufgaben trainiert werden.“

Eine sehr interessante Kernaussage von Lamini ist, dass es nur „3 Zeilen Code“ benötigt, um produktionsreife LLMs auf AMD Instinct GPUs auszuführen. Außerdem soll Lamini den entscheidenden Vorteil haben, dass es auf leicht verfügbaren AMD-GPUs funktioniert. CTO Diamos behauptet auch, dass die Leistung von Lamini nicht von Nvidia-Lösungen überschattet wird, da AMD ROCm „Software-Parität“ mit Nvidia CUDA für LLMs erreicht hat.

Von einem Unternehmen, das sich auf die Bereitstellung von LLM-Lösungen mit AMD-Hardware spezialisiert hat, würden wir so viel erwarten, obwohl sie nicht grundsätzlich falsch liegen. AMD Instinct-GPUs können mit Nvidia A100- und H100-GPUs konkurrieren, vor allem, wenn man genug davon hat. Der Instinct MI250 bietet beispielsweise bis zu 362 Teraflops BF16/FP16-Spitzenrechenleistung für KI-Workloads, und der MI250X bringt es sogar auf 383 Teraflops. Beide verfügen über 128 GB HBM2e-Speicher, was für die Ausführung von LLMs entscheidend sein kann.

Just grilling up some GPUs 💁🏻♀️

Kudos to Jensen for baking them first https://t.co/4448NNf2JP pic.twitter.com/IV4UqIS7OR

— Sharon Zhou (@realSharonZhou) September 26, 2023

AMDs kommender Instinct MI300X erhöht die Speicherkapazität auf 192 GB, was doppelt so viel ist wie bei Nvidias Hopper H100. Allerdings hat AMD die Rechenleistung des MI300 noch nicht offiziell bekannt gegeben – man kann davon ausgehen, dass sie höher sein wird als die des MI250X, aber um wie viel höher, ist noch nicht bekannt.

Zum Vergleich: Nvidias A100 bietet bis zu 312 Teraflops BF16/FP16-Rechenleistung oder 624 Teraflops Spitzenleistung mit Sparsity – im Grunde überspringt Sparsity Multiplikationsberechnungen mit Null, wenn die Antwort bekannt ist, was den Durchsatz verdoppeln kann. Der H100 bietet bis zu 1979 Teraflops an BF16/FP16-Berechnungen mit Sparsity (und die Hälfte davon ohne Sparsity). Auf dem Papier kann AMD also mit dem A100 mithalten, bleibt aber hinter dem H100 zurück. Das setzt aber voraus, dass man tatsächlich H100-GPUs bekommen kann, was, wie Lamini anmerkt, derzeit Wartezeiten von einem Jahr oder mehr bedeutet.

In der Zwischenzeit besteht die Alternative darin, LLMs auf AMDs Instinct-GPUs laufen zu lassen. Ein einzelner MI250X ist vielleicht nicht mit dem H100 vergleichbar, aber fünf davon, auf denen optimierter ROCm-Code läuft, sollten sich als konkurrenzfähig erweisen. Es stellt sich auch die Frage, wie viel Speicher die LLMs benötigen, und wie bereits erwähnt, sind 128 GB mehr als 80 GB oder 94 GB (das Maximum beim aktuellen H100, es sei denn, man bezieht die Dual-GPU H100 NVL mit ein). Ein LLM, der 800 GB Speicher benötigt, wie ChatGPT, würde möglicherweise einen Cluster von zehn oder mehr H100 oder A100 GPUs oder sieben MI250X GPUs benötigen.